INTELIGENCIA ARTIFICIAL

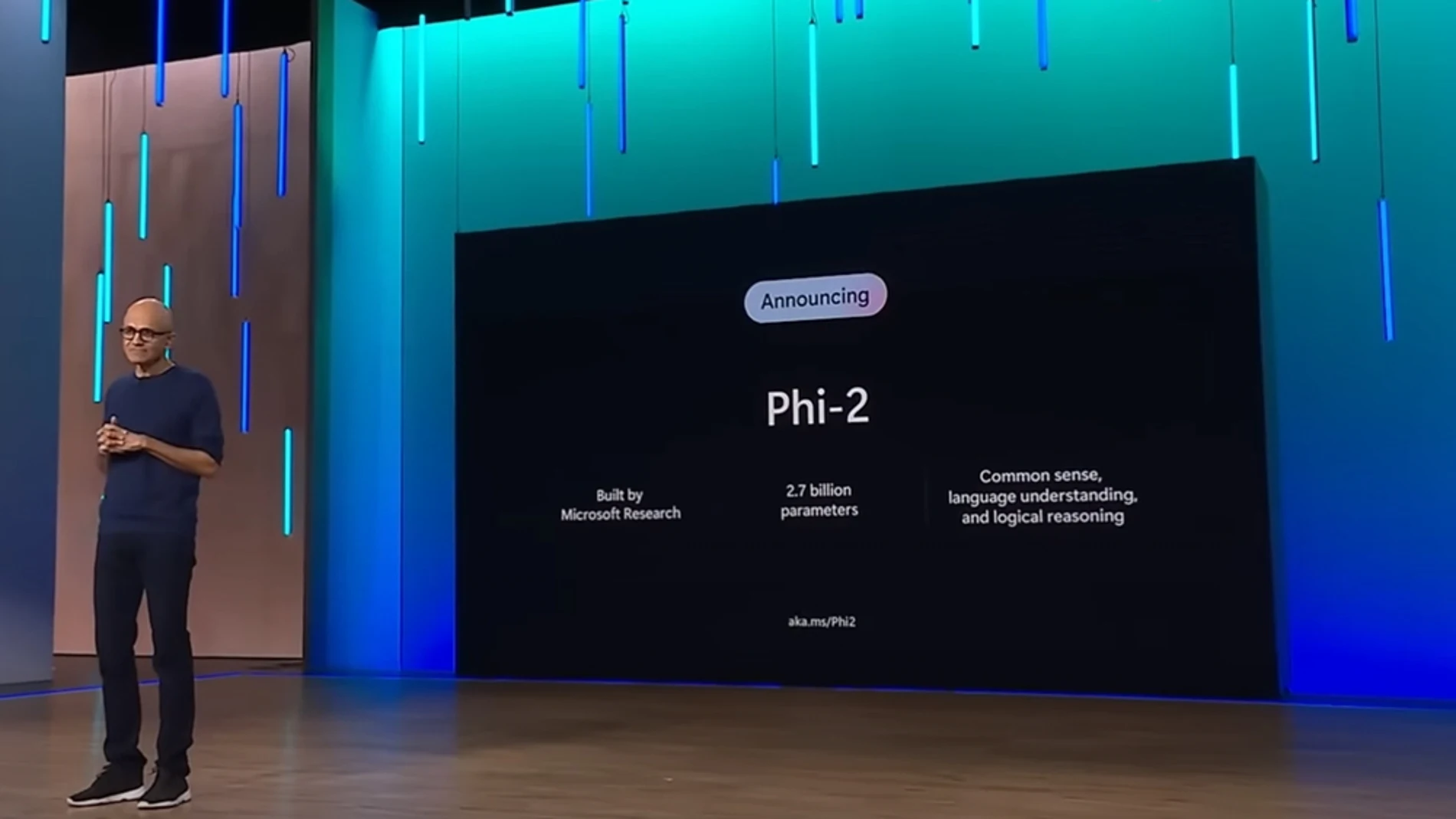

Phi-2, la IA de Microsoft para competir con Llama 2 y Gemini

Se trata de un modelo que implementa 2.700 parámetros enfocados en áreas relacionadas con el razonamiento y la comprensión. Una apuesta para llevar los modelos de lenguaje pequeños (SLMs) a otro nivel.

Parece que Microsoft está decidido a consolidarse como uno de los principales proveedores de IA del mercado. Con un enfoque que va más allá de colaboraciones con gigantes como OpenAI. En este sentido, presentando Phi-2, su próximo modelo de lenguaje que busca competir con líderes como Gemini, Llama-2 (Meta) y Claude-2 (Anthropic). Pero manteniendo un enfoque mucho más reducido y eficiente.

Esto tras el éxito que alcanzaría Phi-1 y su predecesor Phi-1.5, demostrando un profundo razonamiento a la par de otros grandes LLM de la industria. De ahí que el gigante tecnológico decidiera avanzar con el desarrollo de Phi-2. Un modelo que implementa 2.700 parámetros enfocados en áreas relacionadas al razonamiento y comprensión. Una apuesta para llevar los modelos de lenguaje pequeños (SLMs) a otro nivel.

Microsoft Research revela Phi-2, la próxima generación de modelos pequeños de IA

El anunció proviene del departamento de Machine Learning Fundations de Microsoft, que ha presentado su nueva generación de modelos. Éstos destacan ampliamente en las pruebas de rendimiento –pese a no contar con las mismas características de los LLM convencionales–. Asimismo, manifestando que los recursos computacionales no son el factor más determinante a la hora de lograr un rendimiento excepcional en la IA.

Por su parte, Microsoft aclara su intención de posicionar a Phi-2 como un modelo capaz de competir con otros más “generalizados”. En este sentido, sacrificando una base de datos más amplia y optando por un conjunto de recursos pequeños y especializados. Una estrategia que facilita el entrenamiento del SLM, orientándolo a sectores específicos como finanzas, registros, consultorías y más, proporcionando soluciones mucho más precisas.

Microsoft apuesta por la innovación en un tamaño más reducido con Phi-2

Esto se lograría mediante técnicas innovadoras que introdujeron por primera vez con el lanzamiento de Phi-1.5. De esta manera, incrustando todo el conocimiento necesario en los 2.700 millones de parámetros de Phi-2. Lo que a su vez, se traduce en una convergencia más rápida durante su entrenamiento y mejora significativamente su puntuación en la evaluación final del modelo

Básicamente, Microsoft considera el hecho de que modelos grandes como ChatGPT requieren mayor cantidad de recursos para funcionar. Por lo que su entrenamiento resulta costoso y más complicado. Sin embargo, Phi-2 completó su entrenamiento en tan solo 14 días, utilizando 95 GPUs A100. Llegando a igualar o incluso superar “25 veces” el rendimiento de otros modelos de lenguaje más grandes, en tareas como codificación y matemáticas.

Microsoft redefine la IA con un nuevo enfoque

Esta idea de Microsoft surgió como parte de la tendencia de reducir los modelos de lenguaje para hacerlos asequibles. Por lo que en línea con esto, el gigante capacitaría a la IA para tareas específicas que van desde atención al cliente hasta finanzas o aplicaciones de IA generativas. De ahí que sus SLM resulten más accesibles y personalizados, permitiendo que cualquiera aproveche al máximo esta tecnología.

Como resultado tendríamos acceso a modelos de lenguaje más compactos, pero altamente especializados y mejor entrenados. Así pues, superando el rendimiento de los LLM, cuyos conocimientos están dispersos para abarcar diferentes temáticas. Sin mencionar que, sorprendentemente, y pese no contar con retroalimentación humana, Phi-2 destacó un comportamiento más favorable en cuanto a sesgos y alucinaciones.

El impulso de Microsoft hacia las nuevas tendencias de IA

Según declaraciones de Microsoft, desean que Phi-2 sea como un “campo de juego ideal para investigadores”. Ya que no solo ofrece mejoras en cuanto a seguridad y transparencia, sino que también permite experimentar en una amplia variedad de tareas y posibilidades. Además, es importante destacar que ya está disponible en el catálogo de Azure AI Studio, permitiendo que cualquiera aproveche sus capacidades.

En resumen, la nueva estrategia de Microsoft se centra en el desarrollo de una serie de modelos de lenguaje pequeños (SLM) entrenados con conjuntos de datos limitados y un menor número de parámetros. Un enfoque que continúa demostrando sus beneficios, al reducir notablemente los requerimientos necesarios para su funcionamiento. Además que acelera notablemente el tiempo de entrenamiento, enfocándose en tareas específicas.

Claramente, Microsoft está demostrando su compromiso con el avance de la IA, trabajando constantemente en nuevas soluciones. Una visión que continuaría tras el evento del Ignite 2023, donde presentó por primera vez su nueva línea de chips personalizados, Azure Cobalt y Maia. Específicamente diseñados para impulsar el rendimiento de los nuevos modelos de IA del gigante tecnológico.

✕

Accede a tu cuenta para comentar