Actualidad

¿Es cierto que Adobe vende imágenes hechas con IA de la guerra en Gaza?

En su sitio web se pueden adquirir fotografías en las que se puede leer “Generadas con IA”.

Obviamente, es grave clonar las voces y las imágenes de otras personas, como le ocurrió recientemente a Scarlett Johansson. Es sorprendente que logremos traer de vuelta a John Lennon, pero que uno de los gigantes del software y los recursos fotográficos del planeta, como Adobe, venda imágenes generadas con inteligencia artificial de la guerra en Palestina, ya da miedo.

Si accedemos a la web de Adobe y en búsquedas escribimos “Conflicto entre Israel y Palestina”, algunas imágenes se ven reales: la luz, la textura… Todo nos parece indicar que son fotografías verdaderas. Pero otras pueden confundir y es en esa zona gris donde se produce el problema.

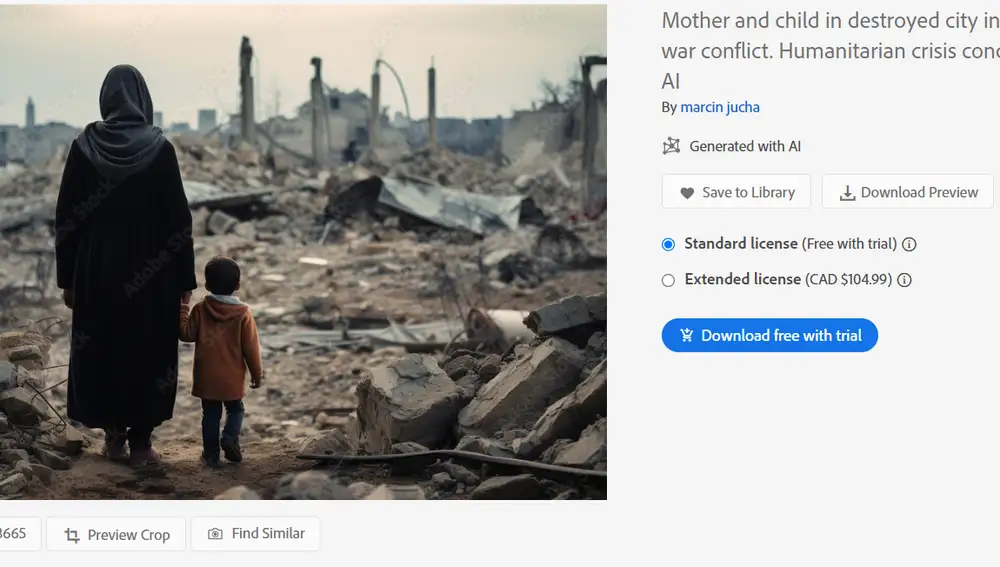

Aunque Adobe señala claramente cuáles son las imágenes generadas por IA, la realidad es que no uno sino varios medios los que utilizan estas imágenes sin advertir que se trata de fotografías tratadas con inteligencia artificial.

En primera instancia no es responsabilidad de Adobe si alguien compra su imagen y no advierte que ha sido creada con inteligencia artificial. Pero la línea también es muy clara cuando hablamos de un conflicto armado y la información debería ser veraz y no aprovecharse para ganar dinero.

Las imágenes van desde niños abandonados en una ciudad destruida, hasta fuego en las mezquitas más conocidas de Jerusalén, pasando por compañías de soldados internándose en campos minados de fuego.

Una imagen muestra a una "madre y su hijo en una ciudad destruida en el conflicto bélico entre Palestina e Israel", un encuadre devastador que fue generado íntegramente por IA. De hecho, es una de una serie de 33 imágenes que muestran una composición similar.

Todas estas imágenes parecen haber sido enviadas por usuarios de Adobe Stock y aparentemente no fueron generadas por el propio Adobe, pero están a la venta en su sitio. Y se difunden por redes sociales como verídicas.

La elección de Adobe de comercializar imágenes generadas por IA vinculadas a un conflicto armado tiene importantes consecuencias a corto y largo plazo. No solo afecta el trabajo y la credibilidad de periodistas que se encuentran en la zona, también inclina la balanza hacia uno u otro lado de la incredulidad, apoyando la difusión de información que no es cierta.

En una entrevista al The Washington Post, Wael Abd-Almageed, profesor de ingeniería de la Universidad de California, lo resumía con mucha precisión: “Una vez que se erosione la línea entre la verdad y lo falso, todo se volverá falso. No podremos creer nada".

✕

Accede a tu cuenta para comentar