Tecnología

Cómo instalar DeepSeek en tu ordenador y ejecutar la IA en local sin que tus datos vayan a China

Te explicamos cómo instalar la IA de moda, o cualquier otra de código abierto como las de Meta, en tu PC o Mac de forma sencilla

La última inteligencia artificial en convertirse en una sensación ha sido DeepSeek. La IA china ha sacudido Silicon Valley por conseguir producir resultados equiparables a los de los modelos de OpenAI y otras tecnológicas con un coste mucho menor. DeepSeek también es de código abierto, al igual que los modelos de Meta y algunos de Google y Microsoft, lo que significa que puede descargarse libremente, cuenta con una licencia MIT que permite un uso comercial sin restricciones, auditarse, modificarse y también ejecutarse de forma local en el ordenador del usuario. Esto es una importante ventaja, dado que, al contrario de lo que sucede al usar el chatbot vía web o app, los datos del usuario no terminarán almacenados en servidores en China.

En este artículo te vamos a explicar cómo puedes descargar e instalar el modelo de lenguaje con facilidad, un procedimiento que también te servirá para probar otros modelos de Meta, Mistral, Microsoft o Google, entre otros proveedores, que son de código abierto.

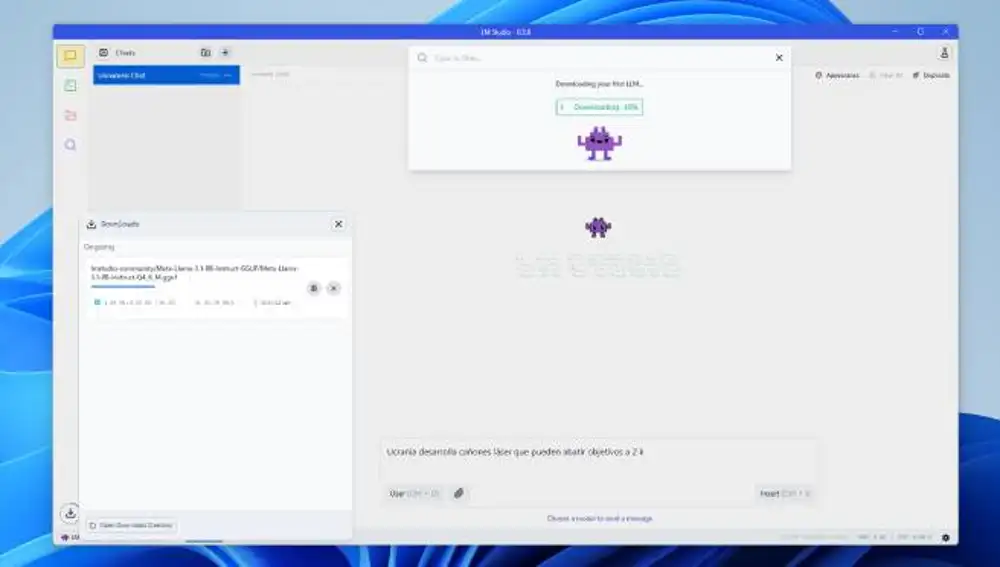

Para hacerlo vamos a usar LM Studio, un programa disponible para Windows, Mac y Linux que facilita la ejecución de grandes modelos de lenguaje (LLM, por sus siglas en inglés) de forma local en el ordenador del usuario, tanto de sobremesa como portátil. La aplicación da acceso a una serie de modelos disponibles y simplifica el proceso de descarga e instalación, además de proporcionar una interfaz similar a la que usan los chatbots online como ChatGPT y compañía.

Por qué un modelo destilado en lugar de DeepSeek completo

Hay que precisar que el DeepSeek que se va a poder utilizar con LM Studio es una versión ‘destilada’ del modelo original completo. Esto es, un modelo más pequeño entrenado para que aprenda a reproducir las respuestas de un modelo más grande, empleando los ajustes y fine-tuning o ajuste fino de este último. Los modelos ‘distilled’ suelen tener menos parámetros, más optimizados, lo que reduce el consumo de recursos y permite ejecutarlos con mayor eficiencia, sin perder demasiado de la capacidad del modelo original.

Esto, más que optativo, es necesario para poder ejecutar un modelo de lenguaje como DeepSeek en un ordenador de consumo. La versión más potente, DeepSeek-R1:671b, tiene 671 mil millones de parámetros y pesa 120 GB tras ser comprimido un 80 % desde los 720 GB originales. Por el contrario, los modelos destilados de DeepSeek no llegan a los 5 GB ni superan los 8 mil millones de parámetros.

Además, están las capacidades de los portátiles y ordenadores de sobremesa que se quedan cortas para un modelo del tamaño de R1:671b. Para probarlo, el youtuber tecnológico Matthew Berman utilizó el servicio en la nube de Vultr que le daba acceso a un servidor con un procesador AMD EPYC 9534 de 128 núcleos, 2,32 TB de memoria RAM, 8 SSD NVMe y 8 tarjetas gráficas AMD Instinct MI300X de 192 GB cada una. Lo que coloquialmente se conoce como un ‘ordenador de la NASA’.

Con el DeepSeek destilado y en un PC de consumo estándar que no sea reciente y no tenga una CPU con NPU (procesadores dedicados al procesamiento de tareas IA), casi todo el procesamiento lo va a llevar la tarjeta gráfica. Y es recomendable que sea dedicada y tenga bastante VRAM, al igual que memoria RAM el equipo. Como referencia, probando el modelo en un equipo con 32 GB de RAM y una gráfica AMD Radeon RX 580 con 8GB de VRAM, es más lento en responder que su contrapartida en la web y app, pero resulta perfectamente funcional. Eso sí, con una carga de procesamiento en la GPU casi del 100%.

Por eso son necesarios los modelos destilados, más ligeros y eficientes. Ahora, si quieres lanzarte a la aventura y probar R1:671b, puedes hacerlo a través de Anywhere LLM, otro programa similar a LM Studio, aunque un poco menos amigable para el usuario principiante, pero que sí lo puede descargar importándolo desde Ollama. Esta es otra herramienta diseñada para ejecutar localmente LLMs, pero con un funcionamiento mucho más árido para el consumidor promedio y que obliga a interactuar con la IA a través de comandos con la Terminal de Windows. Una vez configurado, Anywhere LLM también ofrece una interfaz amigable para usar los chatbots.

Cómo instalar DeepSeek en tu ordenador

Con LM Studio descargado e instalado en tu ordenador, debes seguir estos pasos:

- Abre LM Studio.

- Si es la primera vez que lo utilizas, al iniciarlo te ofrecerá la opción de descargar el modelo Llama 3.1 8B de Meta. Debes aceptarlo para poder instalar luego otros modelos. Una vez descargado, te dará la opción de cargarlo y podrás seguir adelante.

- En el menú de la izquierda con los iconos, haz clic en el de la lupa, Discover.

- En la ventana que se abre, en el apartado Model Search, podrás buscar y seleccionar entre varios modelos disponibles. Introduces en la caja de búsqueda de la parte superior DeepSeek. Tendrás dos opciones correspondientes con R1: DeepSeek R1 Distill (Qwen 7B) y DeepSeek R1 Distill (Llama 8B). Cualquiera de las dos es válida, siendo un poco más pesada la segunda, que cuenta con mil millones de parámetros más. Tras seleccionar, haz clic en el botón verde que dice Download.

- Una notificación emergente te informará de que la descarga ha finalizado y te dará la opción de cargar el modelo. Haz clic en Load Model.

- Con el modelo ya cargado, haz clic en la opción Chat del menú principal, situado en el lateral izquierdo.

- Ahora estás en la ventana de conversación con la IA, pero debes elegir un modelo primero. Haz clic en Select a model to load, el botón en la parte superior de la ventana, y selecciona el de DeepSeek.

- LM Studio te mostrará algunas opciones de configuración del modelo. Haz clic en Load Model y ya puedes comenzar a chatear con la IA. El logo que te mostrará al inicio será el de LM Studio, no el de DeepSeek, y para que te hable en español, tan solo tienes que hacerlo tú primero y abandonará el inglés.

✕

Accede a tu cuenta para comentar